Il terremoto di L’Aquila sbarca in California, negli States, studiato dagli scienziati di tutto il mondo. A Los Angeles, mercoledì 16 settembre 2009, alle ore 8 antimeridiane, gli scienziati italiani dell’Istituto Nazionale di Geofisica e Vulcanologia, W. Marzocchi e A.M. Lombardi, sono stati invitati ad illustrare alla comunità scientifica internazionale di sismologia, i risultati delle loro ricerche sul terremoto che ha devastato L’Aquila il 6 Aprile 2009, il capoluogo della Regione Abruzzo, e sconvolto la vita a oltre 73mila abitanti. In occasione del meeting annuale organizzato dal Centro Sismologico della California Meridionale (SCEC) presso la “University of Southern California” a Palm Springs (Los Angeles) dal 12 al 16 settembre 2009. Come sempre, il meeting è utile e proficuo per condividere e ricevere gli aggiornamenti su progetti di ricerca, attività e collaborazioni. Previsione, prevenzione e decisione, sono i punti-chiave della relazione scientifica dei sismologi. Servono chiari e trasparenti protocolli decisionali utili soprattutto alla Protezione civile, per salvare vite umane, anche qui in Italia.

“Il Southern California Earthquake Center – spiega Warner Marzocchi – è un centro di eccellenza che riunisce tutte le più importanti università americane nel campo della sismologia e lo USGS, il cui scopo è quello di promuovere e organizzare le ricerche nel campo sismologico”. Un totale di 270 lavori scientifici sono stati sottoposti dai sismologi di tutto il mondo presenti al meeting. Durante il quale si è anche parlato dell’esperimento CSEP (Collaboratory Studies for Earthquake Predictability).

Lo scopo del progetto CSEP è quello di fornire un ambiente controllato, in cui possono essere condotti gli esperimenti di previsione dei terremoti. Il protocollo CSEP ha stabilito procedure rigorose per la registrazione e valutazione delle esperienze, così come le norme per le prove comparative delle previsioni. Esperimenti vengono eseguiti su una ben definita piattaforma informatica, sulla base dei codici che sono la componente centrale del CSEP. Il centro di sperimentazione (testing center) europeo è al Politecnico di Zurigo in Svizzera (ricercatori dell'Ingv partecipano attivamente al suo funzionamento) che ospiterà esperimenti per testare le previsioni sismiche nelle varie regioni in Europa.

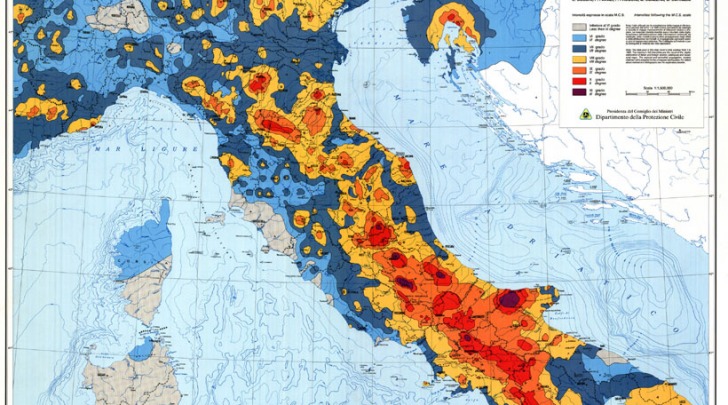

La prima regione scelta è l’Italia, in virtù del fatto che è una delle zone sismiche più attive in Europa ed è capillarmente monitorata dalla strumentazione di rete dell’Istituto Nazionale di Geofisica e Vulcanologia, per garantire un’elevata qualità dei dati raccolti. Diciotto diversi modelli di previsione, sono stati presentati da una serie di ricercatori al CSEP-UE Testing Center presso l’ETH di Zurigo. Previsioni con inizio dal 1 ° agosto 2009 e copertura di 5 e 10 anni, rispettivamente. Inoltre, cinque modelli che forniscono le previsioni a tre mesi e cinque modelli per le previsioni giornaliere.

Come requisito, i codici informatici dei modelli a tre mesi e un giorno, sono stati installati nel centro di prova. Essi vengono periodicamente richiamati, al fine di aggiornare le previsioni, senza interazione manuale. Il centro di test prevede la piena riproducibilità degli esperimenti, perché la creazione di previsione e di valutazione possono essere nuovamente aggiornati automaticamente in qualsiasi momento. Test, quindi, non solo potenziali, ma anche a posteriori possono essere eseguiti nel centro di prova. Nulla è segreto. L’ambizione dell’esperimento è quello di verificare quali modelli di previsione funzionano (e quali no) e quello di quantificare la loro precisione. Il terremoto di L’Aquila delle ore 3:32 antimeridiane del 6 aprile 2009, era un 6.3° della scala Richter. I rapporti e le relazioni scientifiche internazionali dichiarano esplicitamente la magnitudo 6.3. A L’Aquila la cronaca ha registrato 307 morti, 1500 feriti, due milioni di metri cubi di macerie, 1.010 edifici pubblici danneggiati. Si tratta del quinto più catastrofico terremoto nella Storia dall’Unità d’Italia, dopo Messina 1908 (magnitudo 7.1° Richter), Avezzano 1915 (7.0°), Friuli 1976 (6.4°) e Irpinia 1980 (6.9°). A L’Aquila i danni reali, esclusa l'emergenza, le chiese e i monumenti, superano gli 11 miliardi di euro. Per il solo patrimonio artistico si calcola ce ne vorranno almeno 4 solo per il centro storico.

Professor Marzocchi, cosa sta facendo e cosa ha fatto l'Ingv nel campo della previsione dei terremoti?

“L'Ingv ha fornito e sta fornendo con continuità previsioni probabilistiche di lungo e di breve termine. Con le previsioni probabilistiche di lungo-termine si possono identificare (e già lo si è fatto) le aree dove avverranno i grandi terremoti del futuro. Di particolare rilevanza in quest'ambito è la mappa di pericolosità elaborata dall’Ingv nel 2004 (http://zonesismiche.mi.ingv.it/), che fornisce lo scuotimento del terreno atteso nei prossimi 50 anni. Dalla mappa appare evidente che la zona colpita dal terremoto è quella dove ci si aspettavano alti valori di scuotimento del terreno. In generale, questo tipo di studi permette di definire opportuni criteri di costruzione antisimica (a tal proposito, se oggi tali procedure si seguissero alla lettera, la previsione dei terremoti sarebbe di scarsa utilità, poiché i crolli sarebbero minimi). Con le stime probabilistiche di breve termine si può invece monitorare giorno per giorno quali sono le aree in cui il pericolo aumenta”.

Professor Marzocchi, la città di L’Aquila era “compresa” tra le aree a rischio sulla base delle previsioni probabilistiche?

“Per quanto riguarda le previsioni probabilistiche di lungo termine dell'occorrenza dei grandi terremoti, dal 2005 esiste una pagina web (http://www.bo.ingv.it/~earthquake/ITALY/forecasting/M5.5+/) dove vengono fornite stime di probabilità di occorrenza di eventi con magnitudo 5.5 o maggiore in un intervallo di tempo di 10 anni. Essendo time-dependent, le mappe vengono aggiornate ogni 1° Gennaio e dopo ogni evento con magnitudo 5.5 o maggiore. Nella sezione RESULTS di tale pagina web si vede che la zona dove è avvenuto il terremoto aveva la sesta più alta probabilità su 61 zone (di cui 34 con probabilità non trascurabili). Se si guarda la densità spaziale di probabilità, la zona interessata aveva la seconda più alta densità di probabilità su una griglia con 51 nodi”.

Professor Marzocchi, cosa può dirci degli altri studi e ricerche sul terremoto di L’Aquila?

“Altri studi compiuti di recente sullo stesso argomento nell'ambito della convenzione 2004-2006 tra l’Ingv e il Dipartimento della Protezione Civile (Progetto “Valutazione del potenziale sismogenetico e probabilità dei forti terremoti in Italia”) hanno mostrato risultati analoghi. Anche questi studi, che hanno utilizzato modelli di occorrenza dei terremoti del tutto diversi da quelli utilizzati per gli studi appena descritti, hanno identificato l'area di L'Aquila come una di quelle a più alta probabilità di occorrenza di un terremoto distruttivo. La previsione a breve-termine permette di identificare le aree dove più probabilmente avverranno gli aftershock più forti, e con che probabilità essi avverranno. L'Ingv sta fornendo ogni giorno stime di questo tipo alla Protezione Civile. E' importante sottolineare che è la prima volta al mondo che ciò viene fatto durante una crisi. I risultati presentati al recente convegno della European Geosciences Union in una sessione speciale dedicata al terremoto dell'Abruzzo, hanno riscosso un notevole successo. Un'altra iniziativa importante in cui l'Ingv è attualmente coinvolto è il progetto internazionale CSEP (Collaboratory Studies for Earthquake Predictability; pagine web: http://www.cseptesting.org, http://us.cseptesting.org , e http://eu.cseptesting.org). Il progetto nasce con lo scopo di definire un esperimento scientifico per la verifica e il confronto dei diversi modelli di previsione (probabilistica e deterministica) dei terremoti. Tali analisi e confronti sono effettuate in un centro (Testing Center) dove tutti i modelli vengono utilizzati per produrre previsioni indipendentemente dagli autori dei modelli stessi. Le previsioni sono “vere” previsioni, in quanto i dati utilizzati per il confronto sono i terremoti futuri dell’area investigata (il cosiddetto Natural Laboratory). I Natural Laboratories attivi finora sono la California, la Nuova Zelanda, l’Italia, il Giappone, il Pacifico Occidentale e il globo nel suo complesso”.

Professor Marzocchi, cosa ci si può aspettare dai risultati di questo esperimento?

“E’ importante sottolineare che il confronto tra i modelli viene fatto NON in tempo reale. Per avere a disposizione i cataloghi ufficiali è necessario aspettare qualche settimana o pochi mesi. Ciò non è un problema per il CSEP poiché lo scopo dell’esperimento rimane scientifico. Alla fine del periodo di test (che di solito è di 5 anni), l’esperimento si concluderà con una “classifica” dei modelli che si sono comportati meglio nella propria classe di previsione. Di particolare interesse sarà anche il confronto tra le classifiche stilate per tutti i Natural Laboratories per vedere se sono sempre gli stessi modelli ad avere le capacità previsionali migliori. L'esperimento nel territorio italiano sarà condotto per diverse classi di previsione: 1) previsione giornaliera per terremoti di magnitudo superiore a 4 (quattro); 2) previsione trimestrale per eventi di magnitudo superiore a 5 (cinque); 3) previsione quinquennale per eventi di magnitudo superiore a 5 (cinque). I ricercatori Ingv hanno già presentato modelli di previsione probabilistica per la California, la Nuova Zelanda, il Pacifico Occidentale e il mondo (esperimenti già iniziati) e ovviamente saranno presenti anche per l'esperimento condotto in Italia che dovrebbe partire quest'estate”.

Prof. Marzocchi, ci sono stati “precursori” prima del terremoto grazie ai quali si poteva prevedere il sisma di L’Aquila?

“La risposta sintetica è NO. Si è discusso molto di due possibili precursori: 1) le emissioni di radon e 2) la sismicità definita da alcuni come "anomala" e quindi come un potenziale precursore. La difficoltà maggiore nel valutare le affermazioni fatte sulle emissioni del radon come precursore al terremoto del 6 Aprile, sta nel fatto che non esiste nessun articolo scientifico in cui viene descritta anche sommariamente la metodologia usata e vengono presentati i dati. Gli unici due documenti disponibili sono il brevetto dello strumento e una cronistoria dell’intera vicenda”.

Professor Marzocchi, esiste correlazione statistica tra il radon e i terremoti?

“La correlazione statistica tra il radon e i terremoti, come riportata nei grafici, non esiste. Non c'è nessuna indicazione su come si stima l'epicentro e la magnitudo del terremoto. Questo punto è molto importante poiché ha poco senso prevedere terremoti piccoli. La cronistoria riporta molte affermazioni "forti", come quella relativa ad un esperimento di previsione dei terremoti giudicato come "riuscito perfettamente". Purtroppo, non c'è nessun dato o grafico che giustifichi questo entusiasmo. Nei documenti non c'è mai nessun grafico che mostri la variabilità dei picchi in un intervallo di tempo significativo (vengono mostrati dati solo per pochi giorni scelti ad hoc). L'impressione che si ricava dai pochi dati disponibili, è che la stragrande maggioranza delle variazioni siano compatibili con quelle tipiche di un processo casuale di Poisson (che caratterizza i decadimenti radioattivi). Dal punto di vista pratico, se si volessero utilizzare i picchi presenti sui grafici come precursori significherebbe essere quasi sempre in "allarme" (nel grafico riportato in calce al brevetto si vedono più di 15 picchi in un arco temporale di 3 giorni). Come corollario dell'ultima affermazione, si può anche dire che, essendo i picchi di radon molto frequenti, molti terremoti saranno anticipati da picchi. Questo però non vuole dire nulla: avviene semplicemente per caso. Sulla base dei documenti presentati non si può certo escludere che il radon possa essere (in futuro) utilizzato come precursore, o che prima del terremoto di L'Aquila ci sia stato effettivamente un picco. Tuttavia si può affermare che, così com'è descritto, il metodo proposto non ha nessun fondamento scientifico”.

Professor Marzocchi, esistono modelli che utilizzano tale sismicità pre-evento per delle previsioni "deterministiche"?

“Per quanto riguarda la sismicità, esistono modelli che utilizzano tale sismicità pre-evento per delle previsioni "deterministiche". Ad esempio, alcuni modelli interpretano un’accelerazione lineare – ovvero un aumento - della sismicità (o meglio del momento sismico rilasciato) come un precursore di un grande terremoto. A tutt'oggi, comunque, tali modelli non sono in grado di localizzare in anticipo l’epicentro, non forniscono percentuali di “falsi positivi” (o falsi allarmi) e, cosa ancora più importante, non c’è nessuna prova scientifica che confermi la loro capacità di previsione. Per ora, tali modelli possono essere visti solo come in fase molto sperimentale. Per quanto riguarda una previsione probabilistica, si può affermare in generale che l'occorrenza di un terremoto o di uno sciame sismico aumenta la probabilità di avere un terremoto di grande magnitudo. I modelli più utilizzati in ambito scientifico per calcolare la variazione di probabilità indotta da uno sciame sismico sono chiamati ETAS (Epidemic-Type Afteshock Sequence)”.

Professor Marzocchi, come funziona il modello ETAS per la previsione probabilistica dei terremoti in tempo reale?

“Il modello si basa sul fatto che ogni terremoto può generare altri terremoti seguendo regole predeterminate. Tale capacità è funzione della magnitudo e decade nello spazio e nel tempo con leggi di potenza (simili al decadimento spaziale co-sismico e la legge temporale di Omori); il modello stima delle probabilità e non fa delle previsioni "deterministiche"; il modello è usato proficuamente per descrivere le sequenze sismiche di aftershock (come dice il nome stesso), perché, come mostrato in seguito, attribuisce raramente delle probabilità alte di occorrenza ai mainshock; il modello ETAS è uno dei pochissimi modelli che può essere usato in tempo reale per la previsione probabilistica dei terremoti e la sua affidabilità è stata verificata in diverse sequenze sismiche come quella di Landers (California) del 1992 e di Colfiorito (Umbria-Marche) del 1997. E’ utilizzato con successo anche nell’esperimento RELM in California (http://relm.cseptesting.org/); per ora, vengono generate previsioni probabilistica degli aftershock in tempo reale solo in Italia, California e Nuova Zelanda (tra i paesi ad alta sismicità).

La sua applicazione ci ha permesso di ottenere tutti i giorni la previsione probabilistica degli aftershock, quelle che vengono comunemente chiamate scosse di assestamento”.

Professor Marzocchi, avete calcolato l’aumento di probabilità sismica per L’Aquilano?

“Per quantificare l'aumento di probabilità dovuto allo sciame sismico iniziato a Gennaio 2009, è stata calcolata usando il modello ETAS la probabilità di un terremoto di magnitudo Ml 5.5 o maggiore nell'area epicentrale il giorno prima dell'evento (forecast del 5 Aprile 2009 ore 8:00 AM). Tale stima è riportata con la posizione del mainshock. In particolare, la probabilità giornaliera per un terremoto di Ml 5.5 o maggiore per il 6 Aprile in tutta l’area considerata è 10-4 (0.01% se espresso in percentuale). Si può osservare che la probabilità è certamente aumentata rispetto a quanto si poteva stimare in Dicembre prima che lo sciame sismico del 2009 iniziasse, perché ogni terremoto aumenta la probabilità di eventi successivi (sia grandi che piccoli), ma il valore di probabilità per un evento di grande magnitudo rimane molto basso. Questa caratteristica è piuttosto comune per i modelli ETAS ed è la ragione per la quale non sono usati per "prevedere" i terremoti di grande energia, ma piuttosto per descrivere le sequenze di aftershock”.

Professor Marzocchi, come la spiegate?

“Tornando al caso del terremoto del 6 Aprile in Abruzzo, se calcoliamo la probabilità settimanale si ha 7x10-4, o 0.07% se espresso in percentuale. A scopo di verifica è stato calcolata la stessa probabilità settimanale in altri modi; ad esempio, si sono prima contati gli eventi avvenuti la settimana prima (con Ml 1.5 o più grandi), e poi, da tale tasso di terremoti, si è calcolata la probabilità settimanale di avere un terremoto di magnitudo uguale o maggiore di 5.5 utilizzando la legge di Gutenberg-Richter. In tutti i casi, la probabilità settimanale non supera mai lo 0.4% (era 0.01% prima della crisi di inizio anno). Si rimarca inoltre che tali percentuali sono in linea con quanto ottenuto da altri ricercatori analizzando casi analoghi (sia in Italia che in Giappone, California e Nuova Zelanda). In pratica, anche se ogni terremoto aumenta la probabilità di avere terremoti di grande energia, la probabilità raggiunta prima del terremoto de L’Aquila era comunque bassa”.

Professor Marzocchi, che cosa significa? Cosa possiamo sperare di “prevedere” in futuro?

“Che, se si interpreta un incremento di sismicità (e conseguentemente di probabilità) paragonabile a quello precedente l’evento principale del 6 Aprile come un segnale “precursore” di un terremoto, possiamo sperare di “prevedere” alcuni eventi di grande energia (non tutti i grandi terremoti sono anticipati da sciami sismici), ma ci si deve anche aspettare di osservare CENTINAIA di falsi allarmi. Infatti, se le probabilità settimanali sono dell'ordine di 0.1%, significa che ogni mille sciami sismici in media solo uno anticipa di una settimana o meno un grande terremoto”.

di Nicola Facciolini